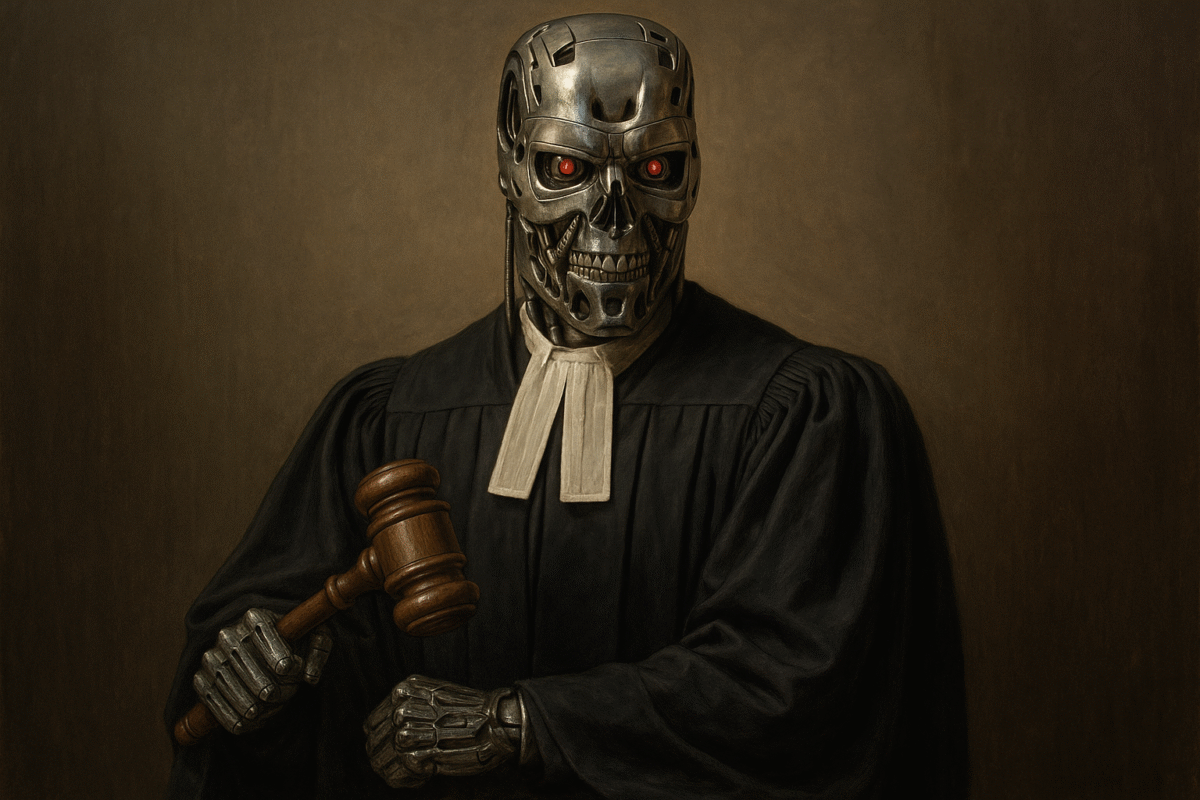

Jueces de EE. UU. enfrentan polémica por uso de IA en fallos judiciales

Washington, D. C. – El uso de inteligencia artificial (IA) en el sistema judicial estadounidense ha pasado de ser una herramienta auxiliar a un foco de controversia, luego de que errores generados por modelos como ChatGPT y otras plataformas se filtraran en decisiones y órdenes judiciales, afectando la precisión y credibilidad de los fallos.

La tendencia comenzó con abogados que presentaron escritos con citas a casos inexistentes, un problema que pronto alcanzó a testigos expertos y, más recientemente, a jueces. En varios estados, magistrados han debido retirar o corregir resoluciones debido a errores atribuibles a la IA, incluyendo un juez federal en Nueva Jersey y otro en Mississippi, este último negándose a explicar las causas de las equivocaciones.

Aunque algunos magistrados, como Xavier Rodriguez, del Distrito Oeste de Texas, defienden usos “seguros” de la IA para resumir expedientes, generar cronologías y preparar preguntas para audiencias, otros alertan sobre el riesgo de confiar en modelos que pueden inventar datos o malinterpretar información legal. “Los abogados han cometido errores mucho antes de que existiera la IA, pero el problema aquí es quién asume la responsabilidad final”, señaló Rodriguez.

Erin Solovey, investigadora en interacción humano-IA, advierte que la línea entre tareas rutinarias y funciones que requieren criterio judicial es difusa y cambia según el contexto. Además, modelos generalistas pueden producir resultados inconsistentes si no están entrenados para fines legales, como resumir documentos jurídicos o reconstruir secuencias de eventos.

Magistradas como Allison Goddard, coautora de las guías publicadas por el think tank jurídico Sedona Conference, reconocen que la IA puede ser útil como “socio de pensamiento” para organizar información, siempre que se evite en procesos críticos como casos penales. “No voy a ser la jueza que cite casos inventados”, afirmó.

Sin embargo, otros como Scott Schlegel, juez de la Corte de Apelaciones de Luisiana, consideran que el uso inadecuado de la IA por jueces es “una crisis en espera de ocurrir”. A diferencia de los abogados, cuyos errores pueden ser sancionados o revertidos, los fallos judiciales erróneos tienen consecuencias inmediatas y duraderas. “Cuando el juez se equivoca, eso es la ley”, advirtió.

Mientras algunos ven en la IA una oportunidad para agilizar un sistema judicial sobrecargado, otros alertan que depender de ella en decisiones sustantivas —como custodia de menores o fianzas— podría socavar la legitimidad de los tribunales. La tensión entre innovación y responsabilidad judicial marca así un nuevo capítulo en la relación entre tecnología y derecho en Estados Unidos.